本文运用逻辑回归对手写数字进行分类预测。。。。

该代码涵盖了基于Python的解决方案,用于Coursera机器学习课程的第三个编程练习。 有关详细说明和方程式,请参阅exercise text。

加载数据集

对于此练习,我们将使用逻辑回归来识别手写数字(1到10)。 我们将扩展我们在练习2中写的逻辑回归的实现,并将其应用于一对一的分类。 让我们开始加载数据集。 .mat文件是在MATLAB的数据存储的标准格式(标准的二进制文件),要在Python中加载,我们需要使用一个SciPy工具。

- 导入相关模块

1 | import numpy as np |

- 加载

.mat形式数据集

1 | data = loadmat('ex3data1.mat') |

{'__header__': b'MATLAB 5.0 MAT-file, Platform: GLNXA64, Created on: Sun Oct 16 13:09:09 2011',

'__version__': '1.0',

'__globals__': [],

'X': array([[0., 0., 0., ..., 0., 0., 0.],

[0., 0., 0., ..., 0., 0., 0.],

[0., 0., 0., ..., 0., 0., 0.],

...,

[0., 0., 0., ..., 0., 0., 0.],

[0., 0., 0., ..., 0., 0., 0.],

[0., 0., 0., ..., 0., 0., 0.]]),

'y': array([[10],

[10],

[10],

...,

[ 9],

[ 9],

[ 9]], dtype=uint8)}- 查看数据集的维度及分析

1 | data['X'].shape, data['y'].shape |

((5000, 400), (5000, 1))好的,我们已经加载了我们的数据。图像在martix X中表示为400维向量(其中有5,000个)。 400维“特征”是原始20 x 20图像中每个像素的灰度强度。类标签在向量y中作为表示图像中数字的数字类。

第一个任务是将我们的逻辑回归实现修改为完全向量化(即没有“for”循环)。这是因为向量化代码除了简洁外,还能够利用线性代数优化,并且通常比迭代代码快得多。但是,如果从练习2中看到我们的代价函数已经完全向量化实现了,所以我们可以在这里重复使用相同的实现。

sigmoid 函数

g 代表一个常用的逻辑函数(logistic function)为S形函数(Sigmoid function),公式为: $g\left( z \right)=\frac{1}{1+{{e}^{-z}}}$

合起来,我们得到逻辑回归模型的假设函数:

${{h}_{\theta }}\left( x \right)=\frac{1}{1+{{e}^{-{{\theta }^{T}}X}}}$

1 | # 定义sigmoid函数 |

交叉熵损失函数

代价函数:

$J\left( \theta \right)=\frac{1}{m}\sum\limits_{i=1}^{m}{[-{{y}^{(i)}}\log \left( {{h}_{\theta }}\left( {{x}^{(i)}} \right) \right)-\left( 1-{{y}^{(i)}} \right)\log \left( 1-{{h}_{\theta }}\left( {{x}^{(i)}} \right) \right)]}$

1 | def cost(theta, X, y, learningRate): |

梯度下降

如果我们要使用梯度下降法令这个代价函数最小化,因为我们未对${{\theta }_{0}}$ 进行正则化,所以梯度下降算法将分两种情形:

$Repeat$ $until$ $convergence${

${\theta_0}:={\theta_0}-a\frac{1}{m}\sum\limits_{i=1}^{m}{(({h_\theta}({{x}^{(i)}})-{{y}^{(i)}})x_{0}^{(i)}})$

${\theta_j}:={\theta_j}-a[\frac{1}{m}\sum\limits_{i=1}^{m}{({h_\theta}({{x}^{(i)}})-{{y}^{(i)}})x_{j}^{\left( i \right)}}+\frac{\lambda }{m}{\theta_j}]$

$for$ $j=1,2,…n$

}

- 以下是原始代码是使用for循环的梯度函数:

1 | def gradient_with_loop(theta, X, y, learningRate): |

- 向量化的梯度函数

1 | def gradient(theta, X, y, learningRate): |

分类器构造

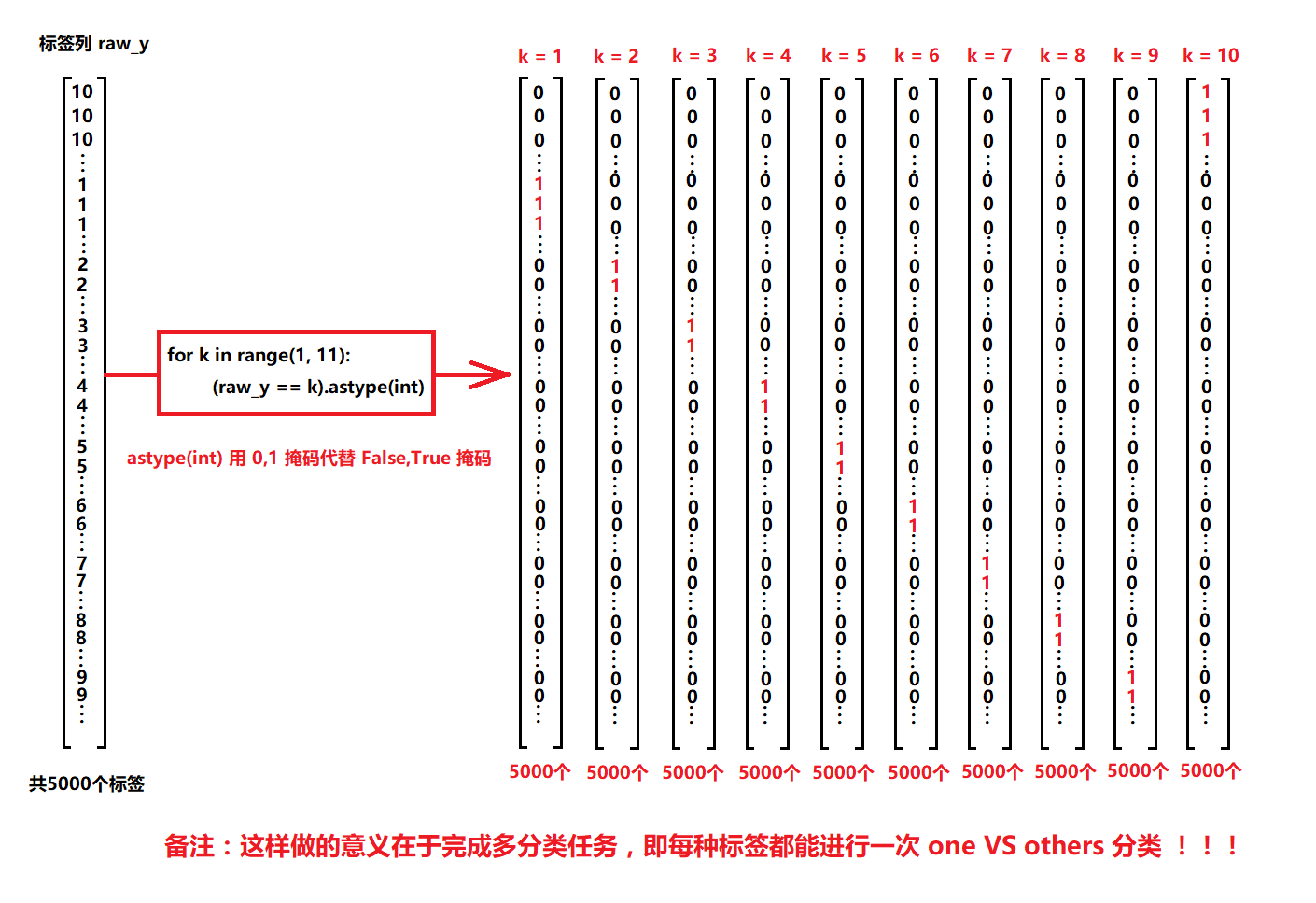

现在我们已经定义了代价函数和梯度函数,现在是构建分类器的时候了。 对于这个任务,我们有10个可能的类,并且由于逻辑回归只能一次在2个类之间进行分类,我们需要多类分类的策略。 在本练习中,我们的任务是实现一对一全分类方法,其中具有k个不同类的标签就有k个分类器,每个分类器在“类别 i”和“不是 i”之间决定。 我们将把分类器训练包含在一个函数中,该函数计算10个分类器中的每个分类器的最终权重,并将权重返回为$k *X(n + 1)$数组,其中n(特征数量)是参数数量,k是k个分类器。

- 向量化标签

1 | from scipy.optimize import minimize |

这里需要注意的几点:首先,我们为theta添加了一个额外的参数(与训练数据一列),以计算截距项(常数项)。 其次,我们将y从类标签转换为每个分类器的二进制值(要么是类i,要么不是类i)。 最后,我们使用SciPy的较新优化API来最小化每个分类器的代价函数。 如果指定的话,API将采用目标函数,初始参数集,优化方法和jacobian(渐变)函数。 然后将优化程序找到的参数分配给参数数组。

实现向量化代码的一个更具挑战性的部分是正确地写入所有的矩阵,保证维度正确。

- 针对加载的数据集,进行简单的维度分析

1 | rows = data['X'].shape[0] # 行数 |

((5000, 401), (5000, 1), (401,), (10, 401))注意,theta是一维数组,因此当它被转换为计算梯度的代码中的矩阵时,它变为(1×401)矩阵。 我们还检查y中的类标签,以确保它们看起来像我们想象的一致。

1 | #numpy unique()保留数组中不同的值 |

array([ 1, 2, 3, 4, 5, 6, 7, 8, 9, 10], dtype=uint8)- 利用开始加载的数据集,让我们确保我们的训练函数正确运行,并且得到合理的输出。

1 | all_theta = one_vs_all(data['X'], data['y'], 10, 1) |

array([[-2.38208691e+00, 0.00000000e+00, 0.00000000e+00, ...,

1.30384042e-03, -6.14427666e-10, 0.00000000e+00],

[-3.18352842e+00, 0.00000000e+00, 0.00000000e+00, ...,

4.46123909e-03, -5.08642939e-04, 0.00000000e+00],

[-4.79735416e+00, 0.00000000e+00, 0.00000000e+00, ...,

-2.87309679e-05, -2.47481807e-07, 0.00000000e+00],

...,

[-7.98467966e+00, 0.00000000e+00, 0.00000000e+00, ...,

-8.97640711e-05, 7.23641521e-06, 0.00000000e+00],

[-4.57003568e+00, 0.00000000e+00, 0.00000000e+00, ...,

-1.33433208e-03, 1.00011405e-04, 0.00000000e+00],

[-5.40502829e+00, 0.00000000e+00, 0.00000000e+00, ...,

-1.16485909e-04, 7.85363055e-06, 0.00000000e+00]])我们现在准备好最后一步 - 使用训练完毕的分类器预测每个图像的标签。 对于这一步,我们将计算每个类的类概率,对于每个训练样本(使用当然的向量化代码),并将输出类标签为具有最高概率的类。

- 进行预测

1 | def predict_all(X, all_theta): |

现在我们可以使用predict_all函数为每个实例生成类预测,看看我们的分类器是如何工作的。

1 | y_pred = predict_all(data['X'], all_theta) |

accuracy = 94.46%在下一个练习中,我们将介绍如何从头开始实现前馈神经网络。